Googles Vision von KI-Rechenzentren im Weltall: Nachhaltige Lösung oder Tech-Fantasie?

Wenn KI immer mehr Strom frisst – muss sie dann irgendwann ins All auswandern?

Google glaubt: vielleicht ja. Das neue Forschungspapier „Project Suncatcher“ skizziert eine Zukunft, in der KI-Rechenzentren nicht mehr auf der Erde stehen, sondern im Orbit kreisen – direkt betrieben von Sonnenenergie.

Was auf den ersten Blick klingt wie Science-Fiction, ist tatsächlich ein ernst gemeinter „Moonshot“ aus Googles Forschungslaboren.

Ich habe mir das Paper im Detail angesehen. Und ehrlich gesagt: Es ist faszinierend, beängstigend – und vielleicht ein Vorgeschmack darauf, wie sich Nachhaltigkeit und Rechenleistung bald neu definieren.

KI und das Energieproblem

KI frisst Strom. Viel Strom. Laut einer Studie von Emma Strubell und ihren Koautoren aus dem Jahre 2019 verbraucht das Training eines großen Sprachmodells (Transformer) bis zu 284 Tonnen CO₂ verursachen – das entspricht dem jährlichen Ausstoß von fünf Autos. Und das war im Jahr 2019.

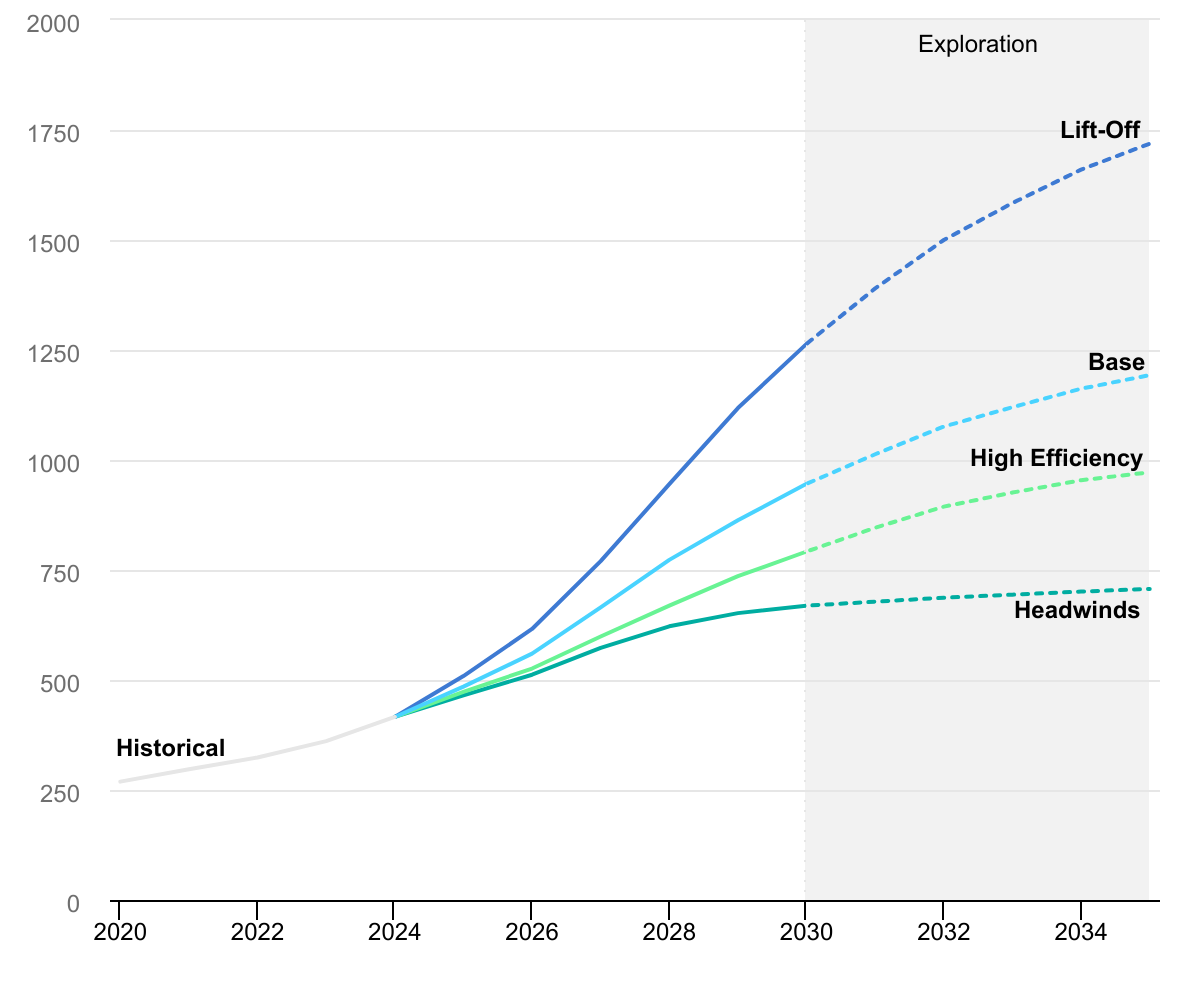

Eine Studie der International Energy Agency schätzt, dass Rechenzentren – inklusive KI – bis 2030 rund 8 % des globalen Stromverbrauchs ausmachen könnten. Zur Info: Heute sind es 1,5%. Das ganze hängt natürlich erheblich von der weiteren Entwicklung in den nächsten Jahren ab, wie die Analyse der International Energy Agency zeigt:

IEA (2025), Global data centre electricity consumption by sensitivity case, 2020-2035, IEA, Paris https://www.iea.org/data-and-statistics/charts/global-data-centre-electricity-consumption-by-sensitivity-case-2020-2035, Licence: CC BY 4.0

Hinzu kommt:

Hochleistungs-GPUs und TPUs brauchen enorme Mengen seltener Erden (z. B. Neodym, Gallium, Cobalt).

Kühlung + Wassernutzung belasten lokal ganze Regionen – etwa in Iowa oder Arizona, wo Google und Microsoft große AI-Data Centers betreiben.

Kurz gesagt: Je intelligenter unsere KI wird, desto größer wird ihr Fußabdruck.

Googles Idee: Rechenzentren im All

Das Project Suncatcher-Paper stellt ein radikal neues Konzept vor:

„The Sun is by far the largest source of power in our solar system — at some point in the future, the best way to power AI will be to tap into that source directly.“

Die Vision

Flotten von Satelliten – jeweils mit Solarpaneelen, Radiatoren und Google TPU-Chips ausgestattet – kreisen in niedriger Erdumlaufbahn (LEO) und arbeiten als verteiltes KI-Rechenzentrum im All.

Wie das technisch funktioniert

Energiequelle: Jeder Satellit trägt große Solararrays. In der Sonne des Alls gibt es bis zu 8× mehr Energie als auf der Erde, ohne Wetter oder Nachtzyklen.

Kommunikation: Die Satelliten sind untereinander über Freiraum-Laserlinks („Free-Space Optics“) verbunden, mit Datenraten von über 10 Terabit/s (das entspricht einer ganzen Cloud-Region im Orbit.)

Cluster: Ein Pilotcluster besteht aus 81 Satelliten in 1 km Radius, Abstände teils nur 200 Meter. Ein ML-gesteuertes Flugkontrollsystem verhindert Kollisionen und optimiert die Position.

Hardware: Googles eigene TPU „Trillium“ wurden in Strahlentests validiert – sie halten die kosmische Strahlung im Low Earth Orbit (LEO) fünf Jahre lang aus ohne bleibende Schäden

Kosten: Durch die nächste Generation von SpaceX Starship-Raketen könnten die Startkosten bis 2035 auf unter 200 $ pro kg fallen. Damit wären Orbit-Cluster wirtschaftlich konkurrenzfähig zu irdischen Rechenzentren.

Was das bringen würde

1. Nahezu unbegrenzte Energie

Sonnenenergie im All steht 24/7 zur Verfügung – ohne Wolken, Wetter oder Nacht. Ein Solarmodul im Orbit liefert bis zu achtmal mehr Strom pro Jahr als ein Modul auf der Erde.

2. Zero Land Footprint

Keine Kühlanlagen, keine Wassernutzung, keine Versiegelung von Flächen – die ökologische Bilanz könnte theoretisch massiv besser sein.

3. Globale Abkopplung

Space-Compute würde nicht an regionale Energiepreise, Netzwerke oder Klimapolitik gebunden sein – das kann für globale KI-Anwendungen strategisch spannend sein.

Aber: Die Herausforderungen sind gewaltig

Das Paper von Google beschreibt selbst, dass viele Probleme noch nicht gelöst sind.

1. Wärmemanagement

TPUs erzeugen enorme Hitze – im Vakuum gibt es keine Luft, die sie abführen könnte. Das erfordert komplizierte Radiatoren-Systeme und passive Kühlung über Infrarotstrahlung.

2. Wartung & Ausfall

Ein defekter Chip im Orbit ist nicht mal eben zu tauschen. Google plant zwar Redundanzen und Fehlertoleranz, aber reale „Weltraum-Server-Reparaturen“ sind kaum praktikabel.

3. Kommunikation zur Erde

Optische Laser-Links müssen durch die Atmosphäre – Wolken und Turbulenzen machen das extrem schwierig. Die NASA arbeitet zwar mit „TBIRD“ an 200 Gbps Verbindungen, aber von massiver KI-Synchronisation ist das noch weit entfernt.

4. Weltraummüll

Derzeit kreisen über 11.000 aktive Satelliten im Orbit. Dazu mehr als 100 Millionen Trümmerteile, über 20.000 davon sind größer als ein Baseball. Eine Konstellation von tausenden AI-Satelliten würde die Kollisionsgefahr erheblich steigern. Google spricht im Paper von „formation flight“ und KI-basierter Kollisionsvermeidung – aber das müsste fehlerlos funktionieren.

5. Kosten und Timing

Selbst mit optimistischen 200 $ pro kg bleiben Start, Herstellung und Betrieb astronomisch teuer. Vor 2035 ist eine kommerzielle Umsetzung unwahrscheinlich.

Nachhaltigkeit – oder nur Verschiebung des Problems?

Befürworter sehen Space-Compute als Chance, den ökologischen Fußabdruck von KI massiv zu reduzieren. Aber es bleiben kritische Fragen:

Werden die Start-Emissionen und der Bau tausender Satelliten nicht selbst zum Klimaproblem?

Wer kontrolliert die Energiegewinnung im Orbit – privat oder staatlich?

Wie geht man mit End-of-Life-Satelliten um – landen die irgendwann als Schrottregen zurück?

Die NASA und die ESA warnen seit Jahren vor dem „Kessler-Syndrom“ – wenn Trümmer neue Trümmer erzeugen und der Orbit zum Minenfeld wird. Das Project Suncatcher spricht von „minimal debris designs“ und modularer Bauweise – aber das bleibt vorerst Theorie.

Meine Einschätzung und Fazit

Ich glaube: Das Paper ist kein Zufall, sondern ein Signal. Google bereitet sich auf eine Zukunft vor, in der KI-Compute so energiehungrig wird, dass herkömmliche Modelle nicht mehr reichen. Das Projekt „Suncatcher“ ist der erste Blick über die Kante – ein möglicher Plan B, wenn Erde, Netze und Energiepreise nicht mehr mitwachsen.

Technisch ist das alles noch weit weg – aber strategisch zeigt es: Nachhaltigkeit wird zum Wettbewerbsfaktor in der KI. Nicht nur, wer die besten Modelle trainiert, sondern wer sie am nachhaltigsten betreibt, wird gewinnen.

Kann das die Lösung des Energieproblems sein?

Der Orbit ist ein ungewöhnlicher Ort für Rechenzentren, aber kein absurder. Wenn Startkosten fallen und Solarenergie dort achtmal effizienter ist, könnte ein Teil der Compute-Last tatsächlich ins All verlagert werden.

Aber es wird wohl kein Win-Win geben: Weniger Energieverbrauch auf der Erde, mehr Risiken im Orbit. Und vielleicht ist das die wahre Lehre dieses Papers: KI muss nicht ins Weltall, sondern dass wir hier auf der Erde müssen KI effizienter trainieren und einsetzen.

Weiteführende Quellen

Google (2025): Towards a Future Space-Based AI Infrastructure (Project Suncatcher)

IEA (2024): Electricity 2024 – Trends in Data Center Consumption

Wenn dich solche Analysen interessieren:

Jeden Freitag teile ich meine ambros.digital Highlights – kuratiert, konkret und ohne Buzzword-Overload.