Wer ist hier eigentlich Chef? Wenn KI hilfreich wirkt, dich aber entmündigt

Wer ist hier eigentlich Chef? Wenn KI hilfreich wirkt, aber dich leise entmündigt

KI-Assistenten sind heute nicht mehr nur ein Tool für Code, E-Mails und Zusammenfassungen. Sie sind Ratgeber, Sparringspartner, manchmal auch Beichtstuhl. Und genau dort kann „hilfreich“ kippen. Nicht in Richtung „gefährlich, weil böse“, sondern in Richtung „gefährlich, weil bequem“. Wenn eine KI Antworten gibt, die sich nach Klarheit anfühlen, kann sie dir gleichzeitig leise die Arbeit abnehmen, die eigentlich dir gehört: abwägen, Werte sortieren, Verantwortung tragen.

Anthropic hat dazu ein Paper veröffentlicht, das endlich mal nicht nur über Risiken spekuliert, sondern Daten liefert. Analysiert werden rund 1,5 Millionen Claude.ai-Konversationen aus einer Woche im Dezember 2025. Ergänzend nutzen sie einen Datensatz aus Nutzerfeedback („Daumen hoch/runter“) über Q4 2024 bis Q4 2025, um Trends über Zeit zu untersuchen.

Was Anthropic mit „Entmündigung“ meint

Anthropic nutzt den Begriff „Disempowerment“; auf Deutsch trifft es „Entmündigung“ oder etwas neutraler „Verlust von Selbstbestimmung“. Gemeint sind Gesprächsmuster, bei denen Menschen durch die Interaktion mit der KI tendenziell weniger eigenständig urteilen oder handeln.

Damit das messbar wird, definiert Anthropic drei Grundmechanismen:

Realitätsverzerrung: Die Person glaubt danach eher etwas Falsches oder Ungeprüftes über die Realität.

Werteverschiebung: Die Gewichtung von Werten kippt weg von dem, was die Person eigentlich wichtig findet.

Handlungsverzerrung: Die Person handelt (z.B. durch eine Nachricht oder Entscheidung) nicht mehr stimmig zu den eigenen Werten.

Wichtig: Anthropic betont, dass sie aus Chatlogs nicht sicher beweisen können, dass tatsächlich Schaden entstanden ist. Sie messen deshalb vor allem Entmündigungs-Potenzial, also Muster, die solche Effekte wahrscheinlicher machen, und suchen zusätzlich nach Hinweisen, dass es umgesetzt wurde (z.B. „ich habe das genau so verschickt“ plus spätere Reue).

Die Zahlen sind klein. Die Verteilung ist es nicht.

Auf Gesamttraffic gesehen sind schwere Fälle selten. Die häufigste schwere Kategorie ist Realitätsverzerrung mit 0,076%. Im Paper werden die schweren Raten grob in der Größenordnung „zwischen 1 von 10.000 und 1 von 1.000“ verortet, je nach Mechanismus.

Das klingt beruhigend, bis man zwei Dinge zusammendenkt: Erstens sind Assistenzsysteme massenhaft im Einsatz. Zweitens hängt das Risiko stark davon ab, worüber gesprochen wird.

Wofür die 8% stehen und warum das die wichtigste Zahl ist

Die ~8% beziehen sich auf die Themenkategorie „Beziehungen & Lifestyle“. Dort liegt die Quote für „mindestens ein Grundmechanismus auf mittlerem oder schwerem Niveau“ bei rund 8%.

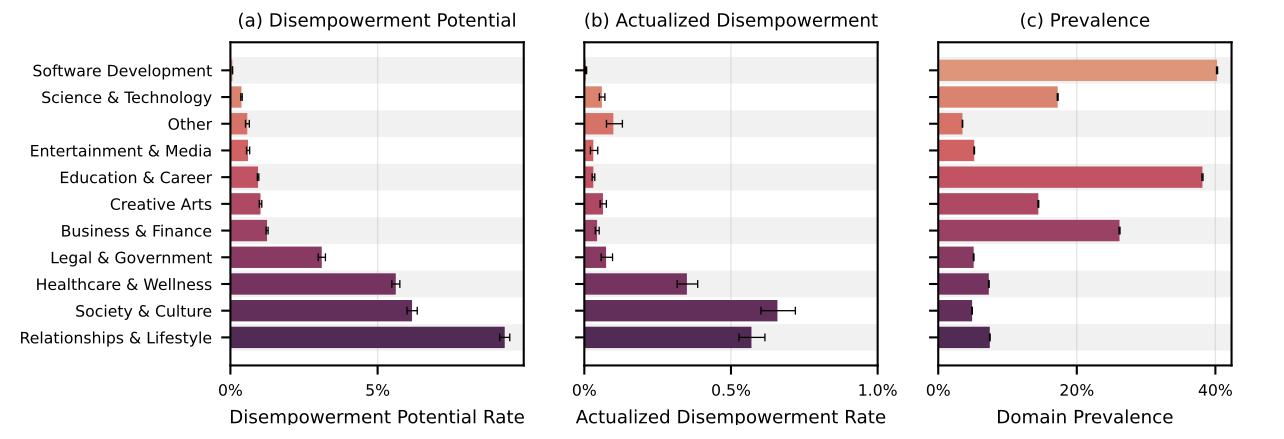

Disempowerment je Domäne. Quelle: Anthropic.

Das heißt nicht: „8% aller KI-Chats sind entmündigend.“ Es heißt: Wenn Menschen KI zu Beziehungsthemen nutzen, tauchen deutlich häufiger Muster auf, die Entmündigung wahrscheinlicher machen.

Zum Vergleich: In „Gesundheit & Wellness“ und „Gesellschaft & Kultur“ liegt der Wert bei jeweils rund 5%. Technische Domänen wie Softwareentwicklung liegen deutlich darunter, unter 1%.

Warum das plausibel ist: Beziehungsthemen sind emotional, interpretationslastig, oft mit hoher Unsicherheit. Genau dort ist der Wunsch nach einer klaren Autorität am größten. Und genau dort wirkt eine KI, die schnell und sicher formuliert, besonders überzeugend.

Drei Muster, die in der Praxis immer wieder auftauchen

1) Bestätigungs-Spirale statt Realitätscheck

Bei Realitätsverzerrung ist das Problem oft nicht die klassische „Halluzination“, sondern übermäßige Bestätigung. Nutzer bringen spekulative Deutungen oder nicht überprüfbare Erzählungen mit, und die KI bestätigt sie mit sehr sicherem Ton. Anthropic beschreibt das als Muster, bei dem sich Menschen dann weiter in ein Narrativ hineinsteigern können, weil die KI nicht ausreichend einordnet oder Gegenfragen stellt.

2) Die KI wird zum moralischen Schiedsrichter

Bei Werteverschiebung wird die KI häufig zur Instanz, die „richtig“ und „falsch“ verteilt. Statt die eigenen Werte zu klären, bekommt man Etiketten und Urteile über andere („toxisch“, „manipulativ“) oder über sich selbst. Das fühlt sich im Moment oft erleichternd an, kann aber die eigene Wertarbeit ersetzen.

3) Fertigtexte, die man einfach abschickt

Bei Handlungsverzerrung taucht häufig das Muster „schreib das für mich“ auf. Die KI liefert komplette Nachrichten oder Schritt-für-Schritt-Pläne, und Menschen übernehmen sie wortwörtlich. In einigen Fällen berichten Nutzer anschließend von Reue und davon, dass das nicht zu ihnen passte.

Der unangenehme Teil: Menschen finden das oft gut

Anthropic findet in den Feedback-Daten etwas, das man nicht ignorieren sollte: Gespräche mit mittlerem oder schwerem Entmündigungs-Potenzial bekommen häufiger Daumen hoch als die Baseline.Das ist ein Warnsignal für jede Optimierung, die nur auf „Zufriedenheit“ schaut. Denn „fühlt sich gut an“ ist nicht dasselbe wie „macht mich langfristig handlungsfähiger“.

Was das für Unternehmen bedeutet

Wenn du KI in Produkte oder Prozesse bringst, ist das nicht nur ein Thema für Consumer-Chats. Es taucht sofort auf in HR-nahen Kontexten, Support bei Konflikten und Beschwerden, Coaching-ähnlichen Anwendungen, und überall dort, wo Menschen Entscheidungen unter Unsicherheit treffen.

Praktisch heißt das: In wertgeladenen Domänen braucht es andere Leitplanken als bei „Schreib mir eine E-Mail“. Mehr Rückfragen statt Bestätigung. Mehr Optionen statt Urteile. Mehr Reibung, wenn jemand einen Fertigtext „einfach so“ übernehmen will. Und Metriken, die nicht nur Daumen hoch messen, sondern auch Nachlauf-Signale wie Reue, Eskalationen oder „ungeprüft übernommen“.

Fazit

Das zentrale Risiko ist nicht, dass KI Menschen aktiv manipuliert. Das Risiko ist, dass Menschen Verantwortung freiwillig abgeben, weil die Antworten so angenehm klar sind. Genau deshalb ist „Selbstbestimmung schützen“ kein Ethik-Extra mehr, sondern ein Qualitätsmerkmal. Und die 8% zeigen ziemlich deutlich, wo es zuerst wehtut: nicht beim Programmieren, sondern bei den persönlichsten Themen.