Generative KI im Gesundheitswesen: Wenn jeder Vierte jede Woche nach Healthcare fragt, ist das kein Randphänomen mehr

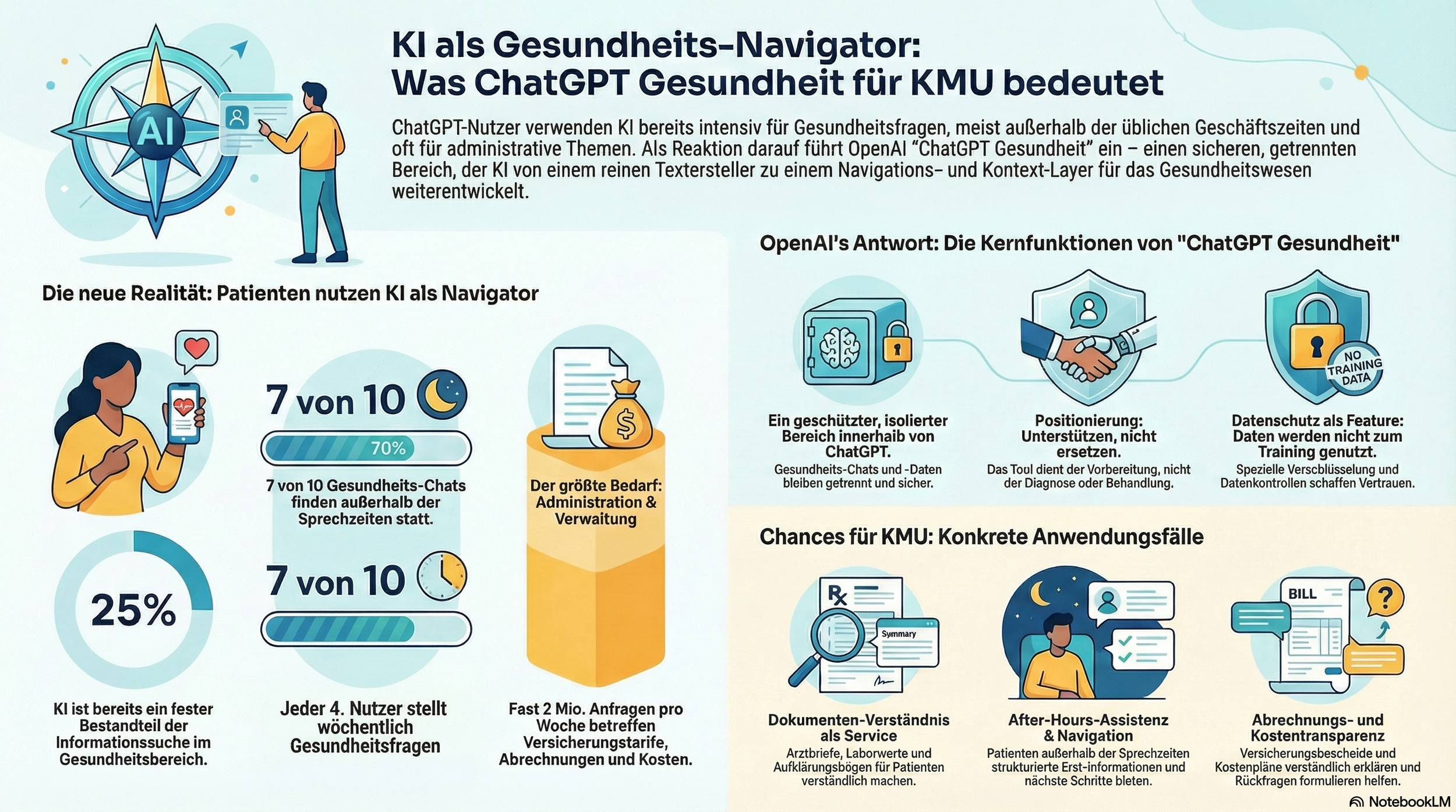

Jeder vierte ChatGPT-User stellt jede Woche eine Frage zu Healthcare. Nicht einmal irgendwann, sondern regelmäßig. Dazu kommt: Mehr als 5 Prozent aller ChatGPT-Nachrichten weltweit drehen sich um Gesundheit. Alles nachzulesen im Bericht von OpenAI.

Das ist der Kontext, in dem OpenAI jetzt ChatGPT Gesundheit startet: eine eigene, abgeschottete Erfahrung, die Gesundheitsinfos sicher mit der Intelligenz von ChatGPT verbindet, damit Menschen informierter und besser vorbereitet sind.

Für das Gesundheitswesen ist das spannend. Für alle KMU, die Healthcare-Prozesse, Patient Journeys, Abrechnung, Portale oder Services anfassen, ist es ein Signal: Der Markt verschiebt sich gerade von „KI kann Texte“ hin zu „KI wird ein Navigations- und Kontextlayer“.

Warum OpenAI überhaupt einen eigenen Gesundheitsmodus baut

Gesundheit ist die Domäne, in der Menschen gleichzeitig maximalen Informationsbedarf und maximale Unsicherheit haben. Und sie haben ein echtes Problem: Informationen liegen verstreut in Portalen, PDFs, Wearables, Notizen, Apps. Genau da setzt die neue Health-Erfahrung an: eigener Bereich, getrennte Chats, getrennte Erinnerungen, optionales Verbinden von Datenquellen, Antworten stärker am eigenen Kontext.

Wichtig ist auch die Positionierung: unterstützen statt ersetzen, nicht für Diagnose oder Behandlung gedacht.

Was die Nutzungsdaten im Report zeigen und warum das für KMU relevant ist

Der beigefügte OpenAI-Report liest sich in Teilen wie eine Prozessanalyse des US-Systems, aber die Muster sind universell:

1) Healthcare ist auch ein Administrationsproblem

Fast 2 Millionen ChatGPT-Nachrichten pro Woche drehen sich um Krankenversicherung, also Tarife vergleichen, Kosten verstehen, Claims, Billing, Eligibility. Das ist der erste wichtige Punkt für viele deutsche Healthcare-KMU: Der größte Hebel liegt oft nicht im medizinischen Kern, sondern im Drumherum. Kommunikation, Dokumente, Aufklärung, Abrechnung, Service.

2) Nutzung passiert oft dann, wenn niemand erreichbar ist

Sieben von zehn Healthcare-Konversationen in ChatGPT finden außerhalb normaler Klinikzeiten statt. Das ist kein Gimmick. Das ist ein klarer Hinweis, wo digitale Assistenz echten Nutzen stiftet: Abends, am Wochenende, zwischen Terminen. Genau da, wo Portale oft nur ein Login anbieten und dann ein PDF ausspucken.

3) Der Report sagt explizit, was die Leute damit tun

Organisieren, Jargon übersetzen, Entwürfe erzeugen, die man dann prüfen kann. Und: Es wird zuverlässiger, wenn Antworten im richtigen Kontext „gegroundet“ sind, zum Beispiel Versicherungsdokumente, klinische Anweisungen oder Portal-Daten. Das ist die Blaupause für produktive KI im Gesundheitswesen: Nicht „clevere Antworten“, sondern „clevere Antworten auf Basis der richtigen Unterlagen“.

Und was ist jetzt neu an ChatGPT Gesundheit

OpenAI beschreibt Health als separaten, geschützten Bereich innerhalb von ChatGPT. Health-Chats, Dateien und Erinnerungen bleiben innerhalb dieses Bereichs, und Health-Inhalte werden nicht zum Training der Foundation-Modelle verwendet.

Außerdem nennt OpenAI zusätzliche Schutzmaßnahmen wie speziell entwickelte Verschlüsselung und Isolierung für Gesundheitsgespräche.

Und: Man kann Datenquellen verbinden, unter anderem Apple Health sowie Wellness-Apps wie Function und MyFitnessPal. Ein Teil der Integrationen, insbesondere Medical Records, ist laut OpenAI aktuell US-only und an Bedingungen geknüpft.

Drei Implikationen für deutsche KMU im Healthcare-Umfeld

1) Patient:innen gewöhnen sich an Erklärbarkeit

Wenn ein Tool Laborwerte, Befunde oder Anweisungen verständlich macht und gleich die nächste sinnvolle Frage für den Arzttermin liefert, dann steigt die Erwartung an alle Touchpoints. Portale, Hotlines, Nachsorge, Aufklärung.

2) Datenschutz wird zum Feature, nicht nur zum Haken in der Checkliste

OpenAI baut Health bewusst getrennt und mit klaren Datenkontrollen. Das ist ein Designpattern, das man auf eigene Lösungen übertragen sollte: getrennte Datenräume, minimaler Zugriff, klare Löschpfade, saubere Protokollierung.

3) Der Wettbewerb läuft über Kontextanbindung und Qualitätssicherung

Der Report sagt es direkt: Antworten werden besser, wenn sie im richtigen patientenspezifischen Kontext verankert sind. Für Unternehmen heißt das: Wer seine Dokumente, Prozesse und Wissensbasen nicht strukturiert bekommt, wird mit generativer KI nie zuverlässig. Und wer zuverlässig ist, gewinnt Vertrauen.

Sechs Use Cases, die ich für KMU jetzt am sinnvollsten finde

Dokumentenverständnis als Service

Arztbriefe, Aufklärungsbögen, Laborwerte, Entlassinfos: Zusammenfassen, erklären, Fragenliste für den Termin erzeugen.After-hours Assistenz für Service und Navigation

Symptom-Fragen nicht diagnostisch beantworten, sondern strukturieren, Red Flags erkennen, nächste Schritte erklären, den richtigen Kanal empfehlen.Abrechnung, Kostentransparenz, Versicherungslogik

Nicht autonom entscheiden, aber verständlich machen: Was bedeutet der Bescheid, welche Unterlagen fehlen, welche Formulierungen gehören in eine Rückfrage. Der Report zeigt, wie dominant dieses Thema in der Nutzung ist.Interne Assistenz für Pflege, Verwaltung und QM

SOPs finden, Checklisten generieren, Übergaben strukturieren, Dokumentationsentwürfe erstellen.Schulung und Simulation

Kurzformate für Clinical Reasoning, Rollenspiele, Fallvignetten. Im Report gibt es dazu Beispiele in Richtung Ausbildungssimulation.Life-Science Ops und Research Support

Literatur sichten, Hypothesen strukturieren, Datenpipelines beschleunigen. Auch dafür zeigt der Report konkrete Praxisbeispiele.

Was du als KMU jetzt tun solltest, wenn du nicht beim Pilot stecken bleiben willst

1) Starte bei einem klaren Prozess, nicht beim Tool

Zum Beispiel: Befund-Erklärung, Call-Center-Entlastung, Nachsorge-Kommunikation, Abrechnungsrückfragen.

2) Baue deine Wissensbasis so, dass KI sie nutzen kann

Dokumente, Formulare, SOPs, Begriffe, Eskalationslogik. Ohne das bleibt es Textproduktion.

3) Definiere Safety-Regeln, die du wirklich testen kannst

Was darf beantwortet werden, was nicht, welche Red Flags führen immer zu Eskalation.

4) Qualität messen

Nicht nur Zeitersparnis, sondern Fehlerklassen, Eskalationsquote, Nachbearbeitung, Nutzervertrauen.

Fazit

Wenn jeder vierte Nutzer wöchentlich Healthcare-Fragen stellt, dann ist generative KI im Gesundheitsbereich nicht mehr Zukunftsmusik, sondern Realität im Alltag. ChatGPT Gesundheit ist dabei weniger „ein neues Feature“ als ein Hinweis auf die nächste Produktkategorie: ein sicherer Kontextlayer, der Menschen durch ein fragmentiertes System navigiert.

Klick den Newsletter

Wenn du keine spannenden KI-Themen verpassen willst, kannst du hier meinen Newsletter abonnieren (einmal wöchentlich)